قانون زیف

قانون زیف (به انگلیسی: Zipf's law، /zɪf/) یکی از قوانین تجربی است. این قانون توسط آمار ریاضی فرمولبندی شدهاست، و به این واقعیت اشاره دارد که انواع مختلف داده (که در علوم فیزیکی و اجتماعی مطالعه میشوند) را میتوان توسط «توزیع زیفی» تقریب زد. این قانون عضوی از خانواده توزیع احتمال قانون توانی است. توزیع زیف با توزیع زتا مرتبط میباشد، ولی باهم یکسان نیستند.

|

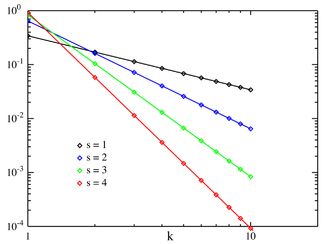

تابع جرم احتمال  تابع جرم احتمال برای N = 10 که در یک مقیاس لاگ-لاگ نمایش یافته است.محور افقی اندیس k میباشد. (توجه کنید که تابع فقط برای مقادیر صحیح k تعریف شده است. خطوط متصل کننده نشاندهنده پیوستگی نیستند.) | |||

|

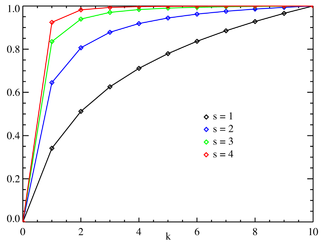

تابع توزیع تجمعی  نمودار تابع توزیع تجمیعی زیف برای N =10. محور افقی برابر اندیس k است. (توجه کنید که تایع فقط در مقادیر صحیح برای k تعریف شده است، و خطوط متصل کننده نشان دهنده پیوسته بودن تابع نیستند.)

نمودار تابع توزیع تجمیعی زیف برای N =10. محور افقی برابر اندیس k است. (توجه کنید که تایع فقط در مقادیر صحیح برای k تعریف شده است، و خطوط متصل کننده نشان دهنده پیوسته بودن تابع نیستند.) | |||

| پارامترها |

(حقیقی) (طبیعی) | ||

|---|---|---|---|

| تکیهگاه | |||

| تابع جرم احتمال | |||

| تابع توزیع تجمعی | |||

| میانگین | |||

| مُد | |||

| آنتروپی | |||

| تابع مولد گشتاور | |||

| تابع مشخصه | |||

قانون زیف در اصل به صورت عبارات زبانشناسی کمی فرمول بندی شد، و بیان میکرد که: اگر به ما چندین پیکره متنی شامل متون زبان طبیعی داده شود، «فراوانی» هر واژه به صورت معکوس با «رتبه» آن در جدول فراوانی متناسب است.

بر اساس قانون زیف، فراوانترین واژه تقریباً دوبرابر دومین واژه فراوانتر رخ میدهد و سه برابر سومین واژه فراوانتر رخ میدهد و غیره.

توزیع رتبه-فراوانی یک رابطه وارون را بیان میکند. برای مثال در پیکره متنی براون که شامل متون انگلیسی آمریکایی است، واژه "the" فراوانترین کلمه است، و خودش به تنهایی ۷٪ از همه رخدادهای واژهها را شامل میشود (یعنی ۶۹٬۹۷۱ تکرار از بین تقریباً یک میلیون). در این پیکره، قانون زیف رعایت شدهاست، یعنی: دومین واژه پرفراوانی که "of" میباشد، شامل تقریباً ۳٫۵٪ کلمات است (۳۶٬۴۱۱ بار رخداد)، و پس از آن واژه "and" میباشد (۲۸٬۸۵۲ بار رخداد). در این پیکره متنی، فقط ۱۳۵ ورودی از دایره واژهها، لازم است تا نیمی از پیکره براون را شامل شود.[۱]

این قانون به افتخار زبانشناس آمریکایی جورج کینگزلی زیف (۱۹۰۲ تا ۱۹۵۰) نامگذاری شدهاست، که آن را به محبوبیت رساند و تلاش کرد آن را توضیح بدهد (زیف ۱۹۳۵ تا ۱۹۴۹)، اما او هیچگاه ادعا نکرده بود که آن را اختراع کردهاست.[۲] به نظر میرسد که تندنویس فرانسوی با نام ژان باتیست استوپ (۱۸۶۸ تا ۱۹۵۰) به این نظم، قبل از زیف اشاره کردهباشد.[۳][در متن مقاله تأیید نشده است] این قانون همچنین در سال ۱۹۱۳ توسط فیزیکدان آلمانی فلیکس آورباخ (۱۸۵۶ تا ۱۹۳۳) اشاره شده است.[۴]

قانون زیف از جمله قوانینی بود که در قرن بیستم مطرح شد و برای نخستین بار به مطالعهٔ مشخصهها و فرایندهای مرتبط با مدارک میپرداخت. جورج کینگزلی زیف، استاد زبانشناسی دانشگاه هاروارد، در سال ۱۹۴۹ با آزمایش کلمات کتاب اولیس جیمز جویس به نتایجی در مورد کلمات و میزان تکرار آنها در متن رسید. نتایج او به این صورت بود که: اگر تمام کلمات یک کتاب را بشماریم و از زیاد به کم مرتب کنبم به این نتیجه میرسیم که رتبهٔ هر کلمه با فراوانی (بسامد) همان کلمه نسبت عکس دارد، یعنی تعداد دفعاتی که هر کلمه در متن ظاهر میشود با رتبهٔ همان کلمه در متن رابطه معکوس دارد. این نسبت در کلمات کل متن برقرار است؛ که به قانون زیف معروف شدهاست. بر طبق زیف کلمهای که در رتبهٔ ۱ قرار دارد دوبرابر بیشتر از کلمهای در متن ظاهر میشود که در رتبهٔ ۲ قرار دارد و ۳ برابر بیشتر از کلمهای ظاهر میشود که در رتبهٔ ۳ قرار دارد و همینطور تا آخر.

او این قضیه را با اصل کمترین کوشش توجیه کرد. انسانها بر اساس این اصل تمایل دارند کارهای خود را به گونهای سادهتر انجام دهند و در نوشتن متنی سعی دارند بیشتر از کلمات تکراری استفاده کنند؛ و همچنین در هنگام صحبت کردن و سخنرانی سعی دارند کلمات کمتری را بیشتر تکرار کنند. زیف بر مبنای اصل کمترین کوشش، اهمیت کوتاهنویسی مقالهها را از طریق بهکارگیری واژههای کمتر برای یک مفهوم مورد تأکید قرار داد. وی در همین زمینه بیان کرد در شرایطی که میتوان برای بیان یک مفهوم از یک واژه استفاده کرد، بهکارگیری واژگان متعدد برای بیان آن مفهوم در یک مقاله بیمعنی است.

این رابطه بین فراوانی f و رتبه r برقرار است که: r * f = k حاصل ضرب فراوانی (بسامد) واژه در رتبهٔ آن در کل هر متن عددی (تقریباً) ثابت است.

رابطهٔ لگاریتمی آن شناختهشدهتر است و کاربرد بیشتر دارد: log r +log f = log c

این رابطه به جز کلمات در بسیاری از دیگر محیطها از جمله جمعیت شهرها، میزان بازدید از صفحات اینترنت، شرکتها و کارکنان آن و نیز در نمایهسازی خودکار و… استفاده میشود. از نظر محققان بسیار عجیب است که چطور و چرا همچنین رابطهٔ سادهای در بسیاری محیطهای پیچیده اتفاق میافتد.

اما به هرحال قانون زیف بسیار سادهاست چراکه خود زیف زبانشناس بود و به مسائل ریاضی چندان علاقه نداشت؛ و این فرمول نتوانست محیطهای خیلی پرتکرار را به درستی نشان دهد. بعد از زیف سه عدد ثابت به این فرمول اضافه شد و کمی محاسبهٔ آن را انعطافپذیرتر کرد؛ که به زیف مندلبرت معروف است.

ƒ=(r+m)^B

جستارهای وابسته

ویرایشپانویس

ویرایش- ↑ Fagan, Stephen; Gençay, Ramazan (2010), "An introduction to textual econometrics", in Ullah, Aman; Giles, David E. A. (eds.), Handbook of Empirical Economics and Finance, CRC Press, pp. 133–153, ISBN 978-1-4200-7036-1. P. 139: "For example, in the Brown Corpus, consisting of over one million words, half of the word volume consists of repeated uses of only 135 words."

- ↑ Powers, David M W (1998). "Applications and explanations of Zipf's law". Association for Computational Linguistics: 151–160.

{{cite journal}}: Cite journal requires|journal=(help); Unknown parameter|conference=ignored (help) - ↑ Christopher D. Manning, Hinrich Schütze Foundations of Statistical Natural Language Processing, MIT Press (1999), شابک ۹۷۸−۰−۲۶۲−۱۳۳۶۰−۹, p. 24

- ↑ Auerbach F. (1913) Das Gesetz der Bevölkerungskonzentration. Petermann’s Geographische Mitteilungen 59, 74–76

منابع

ویرایش- مشارکتکنندگان ویکیپدیا. «Zipf's law». در دانشنامهٔ ویکیپدیای انگلیسی، بازبینیشده در ۱۱ اکتبر ۲۰۲۰.

- نوروزی چاکلی، عبدالرضا (۱۳۹۰). آشنایی با علمسنجی (مبانی، مفاهیم، روابط و ریشهها). تهران: سازمان مطالعه و تدوین کتب علوم انسانی دانشگاهها (سمت)، مرکز تحقیق و توسعهٔ علوم انسانی؛ دانشگاه شاهد، مرکز چاپ و انتشارات، ص ۱۸–۱۹.